Electra(Effective-Learning-based and Computationally-Efficient Language Representation Learning)는 2019년에 Google에서 발표한 언어 모델로, 기존의 언어 모델과는 다른 구조와 작동 원리를 가지고 있다.

구조

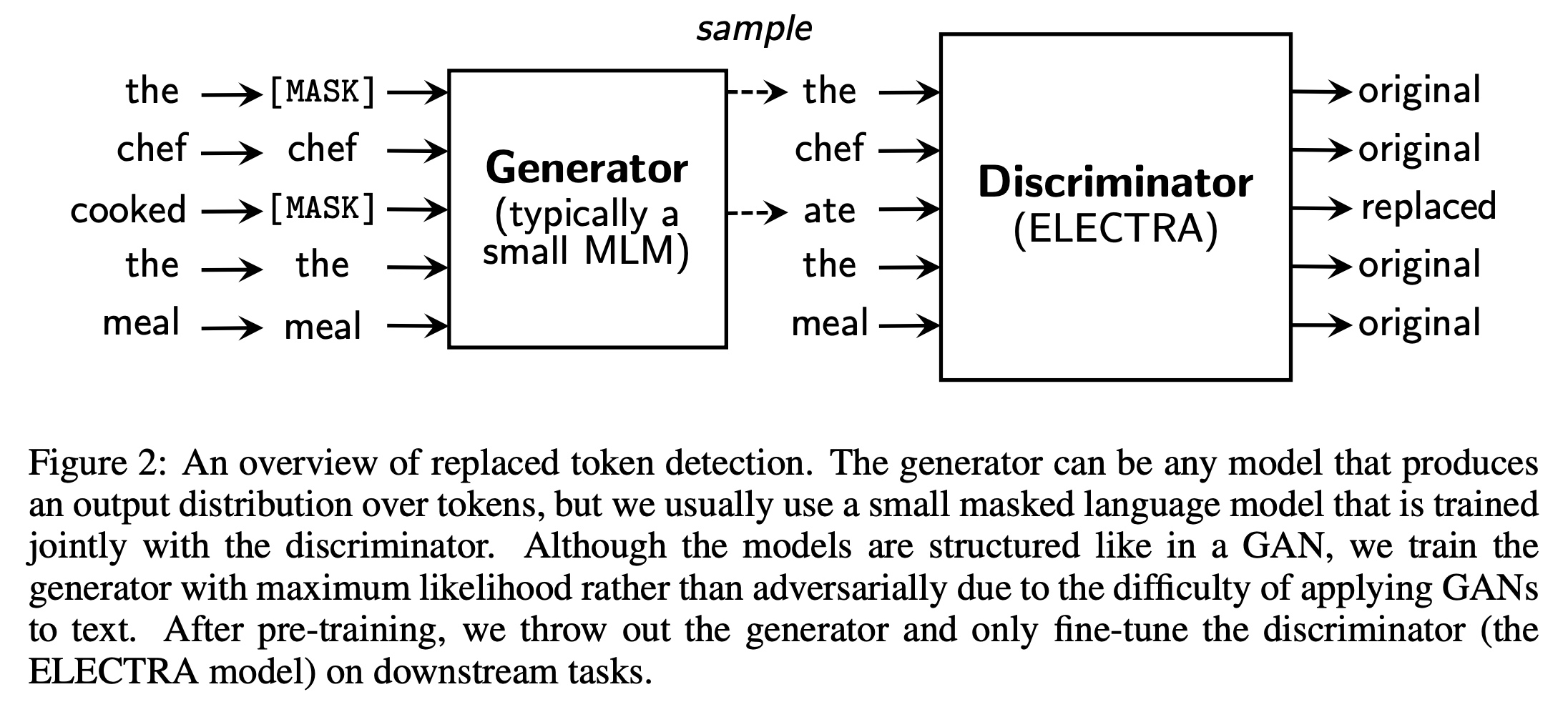

Electra 모델은 GAN(Generative Adversarial Network) 구조를 기반으로 한다. GAN은 생성자(Generator)와 판별자(Discriminator)로 구성되어 있으며, 생성자는 실제와 유사한 데이터를 생성하고, 판별자는 생성자가 생성한 데이터와 실제 데이터를 구분한다.

Electra 모델은 이와 유사하게, 생성자와 판별자로 구성된다. 생성자는 입력 문장의 일부 단어를 마스킹하고, 해당 단어를 예측한다. 판별자는 생성자가 예측한 단어가 실제 단어인지 생성된 단어인지 판별한다.

작동 원리

Electra 모델은 생성자와 판별자를 번갈아가며 학습한다. 생성자는 입력 문장에서 일부 단어를 마스킹하여 다른 단어로 대체한 후, 해당 단어를 예측한다. 이때, 생성자는 실제 단어 대신 생성된 단어를 예측하도록 학습된다. 판별자는 생성자가 예측한 단어가 실제 단어인지 생성된 단어인지 판별한다.

이러한 방식으로 학습을 진행하면, 생성자는 실제 단어를 예측하기보다는 생성된 단어를 예측하도록 학습된다. 이는 생성자가 실제 단어 대신 생성된 단어를 생성하도록 유도하여, 더욱 정확한 언어 모델을 학습할 수 있도록 한다.

Electra 모델은 GLUE, SQuAD, RACE 등 다양한 자연어 처리 작업에서 높은 성능을 보이며, 기존의 언어 모델보다 학습 시간과 메모리 사용량이 적은 장점을 가지고 있다.

샘플코드

아래는 Electra 모델을 구현한 샘플 코드이다.

이 코드는 Electra 모델의 구조를 그대로 재현한 예시 코드로, 입력 문장에 대한 임베딩 레이어와 생성자, 판별자 레이어를 정의하고, 이를 합쳐 전체 모델을 정의한다.

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, LayerNormalization, Dropout

from tensorflow.keras.models import Model

# 입력 문장 정의

input_layer = Input(shape=(128,), dtype=tf.int32)

# 임베딩 레이어 정의

embedding_layer = tf.keras.layers.Embedding(30522, 128)(input_layer)

# 생성자 정의

generator_layer = Dense(128, activation="gelu")(embedding_layer)

generator_layer = LayerNormalization()(generator_layer)

generator_layer = Dropout(0.1)(generator_layer)

generator_layer = Dense(30522)(generator_layer)

# 판별자 정의

discriminator_layer = Dense(128, activation="gelu")(embedding_layer)

discriminator_layer = LayerNormalization()(discriminator_layer)

discriminator_layer = Dropout(0.1)(discriminator_layer)

discriminator_layer = Dense(1)(discriminator_layer)

# 모델 정의

electra_model = Model(input_layer, [generator_layer, discriminator_layer])

# 모델 요약 출력

electra_model.summary()

댓글